CNN学习笔记-过拟合&局部最优

过拟合问题

过拟合问题是由于样本集太小等种种原因,使得模型过度的学习,以至于不仅无法学习到新的特征,反而把某些图片特有的特征当作共性,从而导致整个模型的准确率下降甚至崩溃。例如在识别树叶的过程中,如果存在过拟合问题,可能会把某一片具有锯齿形的叶子过度学习,从而得出只有锯齿形的才是叶子,显然这是错误的。模型过分的拟合了某些数据,使得整个模型的识别能力下降。

过拟合通常通过数据增强,L1,L2正则化,交叉验证方式,适当的时间终止模型训练, dropout等诸多方法解决。

数据增强(Data Augmentation)

数据增强(Data Augmentation)是解决过度拟合常用的方法之一。若在可以增加训练集数目的情况下,通常可以增加新的训练集进行训练,让模型充分学习到所有的特征以至于不会让它过度的学习到某些特征。但在大多数情况下,样本是有限的,无法获得充足的数据集,数据增强就显得尤为重要。

数据增强是指对图片进行一定的操作,例如水平翻转,平移等等。在机器的眼中,这显然就是另一张图片,从而可以学习到新的知识,从而缓减过度拟合问题。

交叉验证方式

传统的模型训练方法只有训练和测试集,用训练集进行训练和计算梯度,用测试集来评估模型的准确率。交叉验证方式通过把训练集按照一定的比例重新规划,通常为7:3的比例重新规划为训练集和验证集,保留测试集。模型仍然通过训练集进行训练,但通过在验证集上进行测试,并运用梯度下降等优化算法,反向传播优化参数从而进行一下轮迭代,这样就可以避免用同一个样本集进行训练和测试的弊端,在一定程度上缓解过度拟合问题。

早停法

在观察模型的学习情况时,随着时间的推移,模型在某个时间点训练集持续保持99.9%甚至100%的准确率,验证集的准确率开始下降,我们就认为模型这时候已经存在过度拟合问题,应当立即停止训练,这在一定程度上也可以缓解过度拟合问题。

Dropout

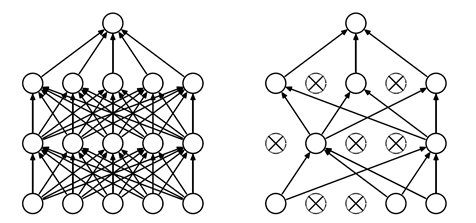

Dropout是由Hinton提出的一种解决过拟合的方法,它的思想是在训练过程随机冻结一部分的结点,从而破坏结点之间的相互依赖的关系,增强结点的独立性,迫使每个结点充分的去学习更加具有鲁棒性的特征,学习更加具有共性的特征,而不依赖于附近的结点,从而提高了整个网络的稀疏性,过拟合问题大大减少。Dropout的参数通常设置在0.3-0.7之间较为合理,即每个神经元丢地的概率。Dropout有效的缓解了小样本难训练的问题,也已经广泛的运用于各大模型中。Dropout过程如下图所示:

正则化

正则化通常分为L1和L2正则化。

L1正则化表达式为:

$$

Loss=E_{in} + \lambda \sum_j |w_j|

$$

L2正则化表达式为:

$$

Loss=E_{in} + \lambda \sum_j w_j^2

$$

L1和L2正则化通过引用惩罚项,使得最小化损失函数时不得不考虑较大的附加参数。由上可以看出,当正则项系数\(\lambda\)很大时,对参数的惩罚也将很大,导致在梯度更新后\(E_{in}\)中对应的\(w_j\)值很小,由此可以使得对某些参数最终接近于0。而正则项系数\(\lambda\)即为模型复杂度的惩罚系数,当其很大时,模型复杂度将变小,不会使得对数据过于拟合。

L1正则化通常用于产生稀疏模型(使得很多\(w_j=0\)),L2正则化通常用于防止过拟合。

局部最优解问题

局部最优解通常指的是目标函数过于复杂,从而使得Loss Function成为非凸函数,从而容易陷入局部最优解,很难求得全局最优解。

解决办法

- 以多组不同参数值初始化多个神经网络,按标准方法训练后,取其中误差最小的解作为最终参数,这相当于从多个不同的初始化点开始搜索,从而可能寻找全局最优。

- 使用模拟退火技术,模拟退火在每一步都以一定的概率接受比当前解更差的结果,从而有助于“跳出”局部极小。在每步迭代过程中,接受“次优解”的概率随着时间的推移而逐渐降低,从而保证算法的稳定。

- 使用随机梯度下降,与标准的梯度下降法精确计算梯度不同,随机梯度下降法在计算梯度时加入了随机的因素。于是,即便陷入局部极小点,它计算出的梯度时加入了随机因素,于是,即便陷入局部极小点,它计算出的梯度可能不为0,这样就有机会跳出局部极小继续搜索。